chapter 15

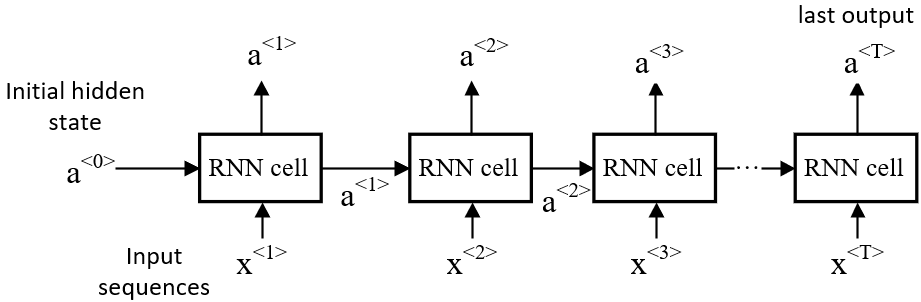

순한 뉴런과 순환층

메모리셀

타임스텝에 걸쳐서 어떤 상태를 보존하는 신경망의 구성 요소

간단히 셀이라고 부른다.

입력과 출력 시퀀스

- 시퀀스 투 시퀀스

- 시퀀스 투 벡터

- 벡터 투 시퀀스

- 인코더 디코더

RNN 훈련하기

BPTT backpropagation through time

시계열 예측하기

타임 스텝마다 하나 이상의 값을 가지면 시계열이라고 부른다 ?

타임 스텝마마나 하나의 데이터를 가진다 → 단변량 시계열(univariate time series)

여러값을 가진다→다변량 시계열(multivariate time series)

기준 성능

RNN 을 시작 하기 전에 기준 성능을 몇개 준비하는 게 좋다

각 시계열의 마지막 값을 그대로 예측 → 순진한 예측 ( navie forecasting)

완전 연결 네트워크 사용

심층 RNN

셀을 여러층으로 쌓는 것 (deep RNN)

긴 시퀀스 다루기

불안정한 그레이디언트 문제와 싸우기

가중치 초기화 ,빠른 옵티마이저 , 드롭아웃 등이 있다.

ReLU는 큰 도움이 되지않는다.

배치 정규화도 RNN 에서 효육적으로 사용 할 수 없다.

RNN에서 잘 맞는 다른 종류의 정규화는 층 정규화이다. (layer normalization)

단기 기억 문제 해결

RNN 을 거치면서 데이터가 변환되므로 일부 정보는 매 훈련 스텝후 사라진다.

- LSTM 셀

- 중요한 입력을 인식하고, 장기상태에 저장하고 ,필요한 기가ㄴ동안 이을 보존하고 , 필요할때 이를 추출하기 위해 학습한다.

- 핍홀 연결

- LSTM 에서 변형괸 , 항상 성능이 향상되지 않는다.

- GRU 셀

- LSTM 간소화 버전이고 , 유사하게 작동하는 것처럼 보임

- 1D 합성곱 층을 사용해 시퀀스 처리

- WAVENET